Readings Newsletter

Become a Readings Member to make your shopping experience even easier.

Sign in or sign up for free!

You’re not far away from qualifying for FREE standard shipping within Australia

You’ve qualified for FREE standard shipping within Australia

The cart is loading…

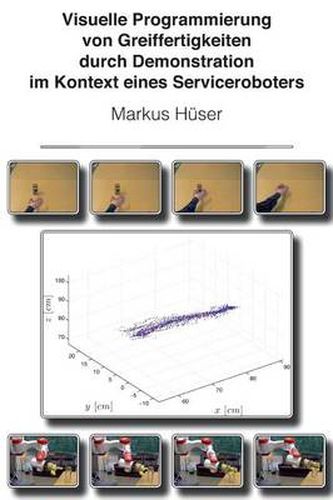

Objekte greifen zu koennen ist eine grundlegende Fertigkeit fur einen Serviceroboter. Sie ist entscheidend fur viele Manipulationsaufgaben sowie fur die Interaktion mit der Umgebung. Die Programmierung solcher Greiffertigkeiten mittels klassischer Roboterprogrammierung ist fur einen Menschen nicht intuitiv und verlangt Expertenwissen. In einem Serviceroboterszenario, das robustes und adaptives Verhalten des Serviceroboters in einer nicht-statischen Umgebung erfordert, wie z.B. in einem Buroszenario, ist es jedoch wichtig, die Interaktion zwischen Roboter und Mensch und damit auch die Programmierung von Greiffertigkeiten zu vereinfachen. Menschen koennen komplexe Bewegungsablaufe durch die Beobachtung eines Instrukteurs erlernen, der die Bewegung mehrmals wiederholt. Basierend auf dieser Beobachtung wird in dieser Arbeit ein Ansatz zur Programmierung von Greiffertigkeiten durch Demonstration fur einen Serviceroboter mit visuellen Sensoren vorgestellt, der dem Prinzip der Programmierung durch Demonstration folgt. Der entwickelte Ansatz ist nicht nur intuitiv und schnell einsetzbar, sondern die Genauigkeit der rekonstruierten Bewegungsablaufe konvergiert gegen die intendierte Bewegung des Instrukteurs. Das vorgeschlagene Verfahren wurde auf der experimentellen Forschungsplattform TASER des Arbeitsbereiches TAMS der Universitat Hamburg implementiert. TASER ist ein mobiler Serviceroboter mit multimodalen Fahigkeiten zur Interaktion zwischen Mensch und Maschine. Der Ansatz wurde sowohl auf synthetisch generierten Bewegungssequenzen als auch auf realen Sensordaten evaluiert, die vom Serviceroboter TASER in einem alltaglichen Szenario aufgenommen wurden. Ground-Truth Daten wurden mit Hilfe synthetischer Bewegungssequenzen zur quantitativen Messung der Abweichung zwischen intendierter Trajektorie des Instrukteurs und rekonstruierter Trajektorie des Roboters generiert. Abhangig von der Anzahl der Demonstrationen und der Art der Trajektorie wird gezeigt, dass die intendierte

$9.00 standard shipping within Australia

FREE standard shipping within Australia for orders over $100.00

Express & International shipping calculated at checkout

Objekte greifen zu koennen ist eine grundlegende Fertigkeit fur einen Serviceroboter. Sie ist entscheidend fur viele Manipulationsaufgaben sowie fur die Interaktion mit der Umgebung. Die Programmierung solcher Greiffertigkeiten mittels klassischer Roboterprogrammierung ist fur einen Menschen nicht intuitiv und verlangt Expertenwissen. In einem Serviceroboterszenario, das robustes und adaptives Verhalten des Serviceroboters in einer nicht-statischen Umgebung erfordert, wie z.B. in einem Buroszenario, ist es jedoch wichtig, die Interaktion zwischen Roboter und Mensch und damit auch die Programmierung von Greiffertigkeiten zu vereinfachen. Menschen koennen komplexe Bewegungsablaufe durch die Beobachtung eines Instrukteurs erlernen, der die Bewegung mehrmals wiederholt. Basierend auf dieser Beobachtung wird in dieser Arbeit ein Ansatz zur Programmierung von Greiffertigkeiten durch Demonstration fur einen Serviceroboter mit visuellen Sensoren vorgestellt, der dem Prinzip der Programmierung durch Demonstration folgt. Der entwickelte Ansatz ist nicht nur intuitiv und schnell einsetzbar, sondern die Genauigkeit der rekonstruierten Bewegungsablaufe konvergiert gegen die intendierte Bewegung des Instrukteurs. Das vorgeschlagene Verfahren wurde auf der experimentellen Forschungsplattform TASER des Arbeitsbereiches TAMS der Universitat Hamburg implementiert. TASER ist ein mobiler Serviceroboter mit multimodalen Fahigkeiten zur Interaktion zwischen Mensch und Maschine. Der Ansatz wurde sowohl auf synthetisch generierten Bewegungssequenzen als auch auf realen Sensordaten evaluiert, die vom Serviceroboter TASER in einem alltaglichen Szenario aufgenommen wurden. Ground-Truth Daten wurden mit Hilfe synthetischer Bewegungssequenzen zur quantitativen Messung der Abweichung zwischen intendierter Trajektorie des Instrukteurs und rekonstruierter Trajektorie des Roboters generiert. Abhangig von der Anzahl der Demonstrationen und der Art der Trajektorie wird gezeigt, dass die intendierte